Продолжая поисковую оптимизацию блога, нельзя упускать из вида такую возможность Blogger, как добавление своего файла robots.txt. С его помощью можно точно указать поисковым роботам правила для индексирования блога и при желании, установить разные параметры для различных поисковых систем.

Продолжая поисковую оптимизацию блога, нельзя упускать из вида такую возможность Blogger, как добавление своего файла robots.txt. С его помощью можно точно указать поисковым роботам правила для индексирования блога и при желании, установить разные параметры для различных поисковых систем.Добавить собственный файл robots в Blogger-блог не составит труда, все делается через панель инструментов. Главная задача состоит в его правильно составлении.

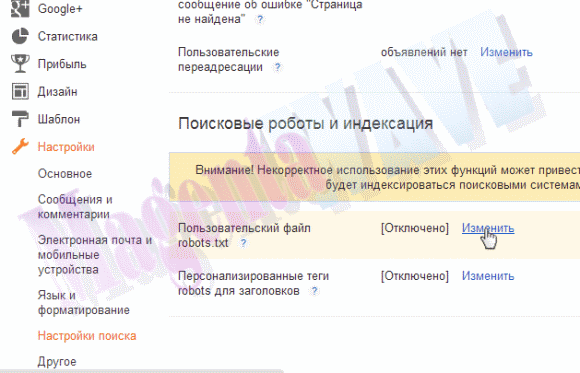

Чтобы воспользоваться данной настройкой, необходимо в админ-панели своего блога зайти на вкладку "Настройки", перейти в "Настройки поиска" где в разделе "Поисковые роботы и индексация" будет пункт "Пользовательский файл robots.txt":

Но основной вопрос остается в том, как же правильно составить собственный пользовательский файл robots. Как это делается можно найти и прочесть в разделе "Помощь" любой вебмастерской поисковиков, где вы уже наверное зарегистрированы, а если нет, то советую вам это сделать. Хорошо изложено здесь. Однако, вкратце опишу структуру. По умолчанию у Blogger такой robots.txt

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /search

Allow: /

Поисковые роботы индексируют сайты по принципу - все что не запрещено, то - разрешено. По-этому существует два принципа записей:Disallow:

User-agent: *

Disallow: /search

Allow: /

1. Запретить все и указать разрешения только для выбранных страниц;

2. Запретить выбранные директории.

Что каждый решает сам. Я сильно не усердствовал просто убрал мета-теги, добавленные ранее.

И еще, можно указать для каждого поисковика свои параметры индексирования через 'User-agent:' например для Яndex - 'User-agent: Yandex' , а для Mail.ru - 'User-agent: Mail.Ru ' , думаю что это гораздо удобнее чем пользоваться мета-тегами.

А вот вариант данного файла, который используется в этом блоге:

Так что теперь можно колдовать и настраивать нужную индексацию своего блога, в любое время, не испытывая ни каких трудностей.

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /search

Disallow: /*archive

Allow: /

User-agent: Yandex

Disallow: /search

Disallow: /*archive

Allow: /

User-agent: Mail.Ru

Disallow: /search

Disallow: /*archive

Allow: /

Sitemap: http://www.magentawave.com/feeds/posts/default?orderby=updated

Может кому приглянется и пригодится.Disallow:

User-agent: *

Disallow: /search

Disallow: /*archive

Allow: /

User-agent: Yandex

Disallow: /search

Disallow: /*archive

Allow: /

User-agent: Mail.Ru

Disallow: /search

Disallow: /*archive

Allow: /

Sitemap: http://www.magentawave.com/feeds/posts/default?orderby=updated

Спасибо большое, я несколько дней искала в коде HTML файл robots.txt, а оказалось все очень просто)

ОтветитьУдалитьА у меня ещё возник один вопрос: я все исправила, как сказано выше, проверила сегодня, а изменения не сохранились(((( Это может быть связанно стем, что когда-то я вручную в код HTML вставляла файл robots.txt?

ОтветитьУдалитьТ.е. - "не сохранились"? Вы внесли изменения, благополучно их сохранили, а потом, на следующий смотрите - а настройки те же? Или я что-не понял. Обычно если все записи в файле сделаны верно, то все прекрасно сохраняется.

Удалить"вручную в код HTML вставляла файл robots.txt" - как вам это удалось?!? Но если это чудо у вас в коде шаблона, то его оттуда нужно незамедлительно извлечь, а в настройках прописать все заново.

P.S. Сейчас выложу свой файл robots.txt, может пригодится, сразу как-то проморгал этот момент.

Да имеено так все и было, как в первой строчке у вас написано!

УдалитьА как убрать не знаю, я тогда очень долго искала, как мне поместить этот файл, в итоге нашла, что его нужно вставить после тега <head вроде бы все так и сделала! Потом нашла вашу статью-все исправила. как описано в посте, проверила через вебмастера яндекс - все было как надо, а сегодня зашла в вебмастер, а он мне снова выдает старый файл(((

А ещё в robots.txt, который размещен выше вы запретли искать архив и поиск, а все остальное индексировать разрешили, правильно? А ещё в Sitemap нужно вставить адрес свего блога, да?

Спасибо вам заранее за ответы))

Это не поиск :) Это страницы ярлыков (тегов), все остальное разрешил, для Гугла вообще оставил все как есть. Но вариантов много и разных я себе сделал такой. Насчет Sitemap - конечно нужно адрес своего блога ставить :)

УдалитьДобрый день, может быть вы сможете, мне помочь, при проверке роботекс в яндексе он пишет:"Файл robots.txt не будет учтён роботом Яндекса, т.к. при запросе выполняется перенаправление."

ОтветитьУдалитьроботекс выглядет так

User-agent: Mediapartners-Google

Disallow:

User-agent: Yandex

Disallow:

User-agent: Mail.ru

Disallow:

Главным зеркалом я выбрала сайт без www, но это уже было после того, как яндекс выдал сообщение о перенаправлении, пробовала вставить host, но блоггер пишет, что форматирование некорректно, что мне делать?)

Такое в Я-Вебмастер написано потому что для России в Blogger ввели региональные домены (если пользователь из России, то домен будет не http://***.blogspot.com , а http://***.blogspot.ru) это сделано при помощи серверного перенаправления, соответственно вот Яшка и ругается. Но у вас же открыт блог для поиска? Значить и переживать не стоит.

УдалитьЗ.Ы. Раз уж вы решили сделать такой роботс, то можно было оставить и стандартный, от этого мало что изменилось бы.

Спасибо за ответ, а я могу это как-то исправить, самостоятельно?

ОтветитьУдалитьПеренаправление? Это вряд ли, на бесплатных доменах пока все так, да и исправлять ничего не нужно - добавьте тот что есть роботс, все будет в порядке.

УдалитьСпасибо)

Удалитьдобрый день!

ОтветитьУдалитья создал вот такой блогосайт salken.ru

создал статические страницы на боковой панели.

они в фид АТОМ не попадают.

соответвенно столкнулься со след. проблемой:

яндекс не видит статические страницы. чтобы увидел ему нужен сайтэп. в блоггере как мне стало известно вместо сайтмэп используется фид атом.

скажите вы знаете как и куда выложить сайтмэп сделанный мной ?

Зачем это делать? Статические страницы чудесно залетают в индекс Яндекса без дополнительных гемороев, по крайней мере так було у меня пока я в роботс это дело не перекрыл(в личных целях). Добавить свой файл карты сайта, на сколько я знаю , на Блоггер в данный момент возможности нет.

УдалитьЗдравствуйте,у меня есть блог на Blogger,я добавил в Пользовательский файл robots.txt

ОтветитьУдалитьUser-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /search

Disallow: /*archive

Allow: /

User-agent: Yandex

Disallow: /search

Disallow: /*archive

Allow: /

User-agent: Mail.Ru

Disallow: /search

Disallow: /*archive

Allow: /

Sitemap: http://online-zarobotok.blogspot.com/atom.xml?redirect=false&start-index=1&max-results=500

это правильно?

и мне не нужно ничего больше делать? или в яндекс нужно еще и проверять robots.txt ? просто когда я ввожу то что я написал выше,то что у меня стоит в блоге robots.txt,то в яндексе пишет "строка 9-12 и 19-19 что это может быть? это значит что что то не так?

Составлен, вроде, верно, только я на счет карты сайта не совсем понял, это вы фид с Атома дернули, такого еще не встречал, где откопали, если можно ссылку.

УдалитьНа счет нужно делать или нет, все зависит от потребностей.

В Яндексе показывает какие строчки robots.txt будут учтены его поисковым роботом при прохождении вашего сайта.

дошло до меня наверное :)

ОтветитьУдалитьой я не помню сидел дня 2 менял эти штуки:) где то в гугле мне эту сылку дали:)

Спасибо огромное за информацию. Очень пригодилась. Долго правда искал как создать свой Sitemap и куда его потом вставлять, но все таки разобрался.

ОтветитьУдалитьВот кстати ссылка на сайт где автоматически создается файл Sitemap и перебрасывается на сайт: http://ctrlq.org/blogger/

добрый день, что-то я не поняла с robots.txt, у меня стандартный, но при этом в поиске яндекса (смотрю в вебмастер.яндекс.ру) находятся только три (!) страницы - это главная (т.е. лалала.блогспот.ру) и две ссылки на два поста, по какому принципу выдернутые роботом, не знаю.

ОтветитьУдалитьнормально ли это? мне кажется, это какая-то кривая индексация. хотелось бы побольше страниц в поиске. (в результате очень плохо представлена в яндексе по низкочастотным запросам, хотя контекст качественный, оптимизированный, перелинковка и т.п.) в гугле же наоборот хорошо представлена

Так и есть - кривая индексация. Для улучшения, крайне советую проделать шаги оптимизации описанные здесь - http://www.magentawave.com/2012/01/blogspot-blogger.html

УдалитьСпасибо за информацию. Везде рекомендации только о закрытии search, а про архив что-то все умалчивают.

ОтветитьУдалитьУ меня в robots были крыты search, а archive по глупости индексировался. Только сейчас разобралась благодаря вам.

Спасибо, очень интересно и полезно. Попробую применить Ваш шаблон.

ОтветитьУдалитьПожалуйста, только не забудьте вписать адрес своего сайта )

УдалитьUser-agent: Mediapartners-Google

ОтветитьУдалитьDisallow:

User-agent: *

Disallow: /search

Allow: /

У меня стоял такой файл страницы кроме главной не шли в индекс. Удалив запись /search пошли страницы в индекс. Как вообще удалить роботс файл? я его на блоге удаляю а в search concole он все равно прописан.

User-agent: Mediapartners-Google

ОтветитьУдалитьDisallow:

User-agent: *

Disallow: /search

Allow: /

Извините конечно но этот файл запрещяет индекст вот скриншот примера что индекс запрещён http://prnt.sc/ako2yd

Ссылка, которую вы привели в примере это ссылка станицы поиска по блогу или ярлыка, естественно что она запрещена правилом в роботс.тхт. При стандартном роботс все нормально индексируется, только нужно подождать, станицы ярлыков (/search) индексируются быстрее потому что на них много внутренних ссылок, это конечно плюс, но с другой стороны это приводит к появлению многих дубликатов в поисковой выдачи и дублированию контента, что уже более существенный минус.

УдалитьЗдравствуйте! Не подскажете почему робот яндекса не видит файл? Пишет » Сервер отвечает редиректом на запрос /robots.txt «

ОтветитьУдалить